IA e EDUCAÇÃO

EDUCAR PARA O PENSAR COMPLEXO

As tecnologias de IA não são apenas ferramentas, mas sim um conjunto de sistemas computacionais com base em modelos estatísticos de probabilidade capazes de fazer correlações e identificação de padrões em dados. Em educação, precisamos ir além da visão instrumental de atribuir à IA o papel de trazer inovação para o contexto de ensino e aprendizagem.

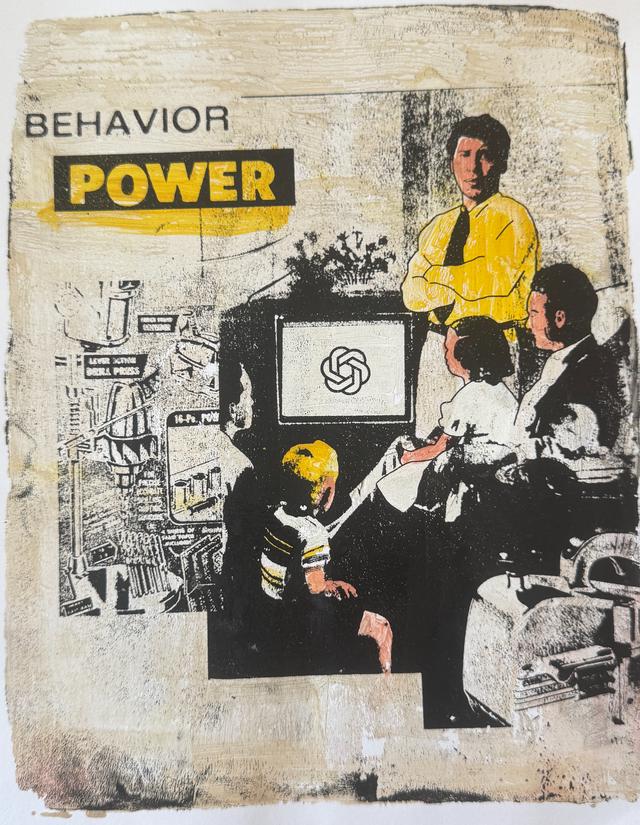

Imagem: Bart Fish & Power Tools of AI

ENCOMENDE SEU LIVRO

Com base na teoria do pensamento complexo de Edgar Morin, Inteligência além da Artificial: Educar para o Pensar Complexo convida a religar os sabers do campo de conhecimento da educação com os do campo da IA. Uma pesquisa de mestrado (PUC-SP) transformada em livro, com linguagem acessível, para dialogar não apenas com pesquisadores, mas com qualquer pessoa curiosa sobre o tema. Produzido pela Z Edições, uma editora alternativa que também publica os quadrinhos da cartunista Laerte, pode ser adquirido sob demanda. Faça seu pedido aqui

Vídeo gravado para o 13º Congresso Brasileiro de Linguística Aplicada

ALÉM DO USO DA IA

O modelo de ensino ainda se pauta fortemente na formação de cidadãos funcionais, prontos para atender à demanda do mercado de trabalho da economia industrial. Por essa perspectiva, valores associados ao rendimento e à produtividade invariavelmente aparecem na frente de outros ligados ao respeito à coletividade, incentivo à criatividade, resiliência, solução de problemas, dentre outros.

No entanto, educar envolve uma complexidade de situações, contextos, agentes, condições e estruturas que vão muito além de adquirir competências sobre como “usar” IA para ensinar conteúdos curriculares. Isso porque a IA – e todo seu sistema de infraestrutura envolvido – também nos usa o tempo todo.

Da técnica à ética: perguntas críticas

CLIQUE e REFLITA:

Precisamos mesmo da IA?

Por mais que a todo momento escutemos que temos que usar IA em práticas pedagógicas, precisamos parar para pensar se realmente a introdução de uma aplicação de IA vai aprimorar a prática que planejamos. A prática seria possível sem IA? Que benefícios a introdução da IA vai trazer para professores e alunos envolvidos?

Ainda que a resposta seja “sim”, é preciso escolher “qual” IA vamos trazer para a sala de aula.

Podemos confiar na IA?

A rápida disseminação de textos, imagens e vídeos produzidos por IA está trazendo novos desafios para a qualidade da informação que circula na sociedade. Em áreas sensíveis, como medicina, governo, direito e educação, esse problema pode ter consequências sérias. Um dos riscos mais discutidos é a desinformação: quando o sistema de IA cria conteúdos imprecisos, enganosos ou até completamente inventados, considerando que funciona a partir de correlações entre os dados de treinamento.

Nem todas as falhas são fáceis de perceber, muitas são sutis e difíceis de identificar, o que as torna ainda mais perigosas. Outro ponto de atenção é a geração de conteúdos padronizados e de baixa qualidade, que poluem a internet e as redes sociais.

A IA é enviesada?

Se os dados usados para treinar o modelo de IA já possuem vieses, as respostas também serão enviesadas. No caso de modelos como o GPT-4, os conjuntos de dados exatos não são conhecidos, mas sabemos que eles se baseiam em enormes quantidades de textos produzidos por humanos e coletados da internet aberta — como por exemplo, de sites como Reddit, Wikipedia e inúmeros fóruns e páginas. Pesquisadores que analisam a ética dos LLM lembram que a internet é dominada por visões hegemônicas, marcadas por perspectivas racistas, misóginas e etaristas. Quando a IA é treinada nesses dados, o risco de reproduzir e até amplificar essas visões de mundo é alto.

Um exemplo claro desse problema é a diversidade linguística, já que existem mais de 7.100 idiomas falados no mundo, mas apenas uma pequena parcela está documentada na internet — e menos ainda são contemplados pelos modelos de IA generativa. Isso significa que muitas vozes e culturas ficam invisíveis nesse processo.

É preciso avaliar criticamente as respostas produzidas, que começam na seleção dos dados, passando pela forma como são rotulados ou filtrados, até as próprias perguntas (prompts). Quem está sendo representado e quem está sendo deixado de fora?

Quem constrói a IA?

Quem se beneficia da IA?

A chamada “divisão digital” se refere à distância crescente entre pessoas, comunidades e empresas que têm acesso às aplicações mais avançadas de IA e aquelas que não têm. Hoje, cerca de 1/3 da população mundial (aproximadamente 2,6 bilhões de pessoas) não tem acesso regular à internet e, portanto, tampouco à IA.

Essa desigualdade não se limita apenas ao acesso físico à tecnologia (como computadores, softwares ou assinaturas de IA), mas também envolve diferenças de formação educacional fundamental para usar a IA de maneira crítica e produtiva.

No mercado de trabalho, essa realidade afeta de forma mais dura os empregos de baixa remuneração ou rotineiros que correm maior risco de substituição pela IA. Em nível industrial, o controle e o desenvolvimento da IA avançada, incluindo infraestruturas físicas, estão concentrados em grandes corporações bilionárias — como Meta, OpenAI, Amazon, X, Google e Microsoft. Embora pequenas startups também participem desse campo, elas enfrentam muitas barreiras, como os altos custos de treinar modelos de linguagem e a dificuldade de acessar bases de dados de qualidade.

A IA é sustentável?

O acelerado crescimento da IA traz impactos ambientais importantes, despertando preocupações sobre sustentabilidade e pegada de carbono. Sistemas de IA exigem enormes quantidades de poder computacional, o que pode resultar em algo consumo de energia e emissão de gases de efeito estufa. Os data centers sustentam as operações de IA e contribuem ainda para a degradação ambiental, o consumo de água, energia e o aumento de lixo eletrônico.

Pesquisas da especialista em sustentabilidade da IA, Sasha Luccioni, mostram que gerar respostas de texto com IA, como as de ChatGPT, consome 30 vezes mais energia do que extrair o mesmo texto de uma fonte existente.

A IA rouba produções e conteúdos?

Para muitos usuários, a IA parece mágica, pois consegue gerar imagens, escrever textos e resumir tópicos complexos em pontos simples. Mas todo esse conhecimento vem de enormes quantidades de conteúdos criados – licenciados ou não – por seres humanos na internet, incluindo vídeos transcritos do YouTube, discussões no Reddit, bibliotecas de imagens e todo o texto da Wikipedia.

Isso levanta uma questão legal e ética: as empresas de IA estão violando direitos autorais ao usar esse conteúdo sem permissão? O New York Times, diversos autores, artistas e músicos acreditam que sim. Eles entraram com processos contra empresas como OpenAI e Meta, argumentando que seus trabalhos alimentam os modelos, mas sem receber crédico, atribuição ou compensação financeira.

As empresas de IA se defendem citando a doutrina do “uso justo”, argumentando que os resultados da IA são combinações computacionais que se diferenciam do trabalho original. Porém, muitas questões legais ainda estão sem solução, e cresce a frustração dos setores criativos.

A IA espia e nos vigia?

Recentemente, Sam Altman, CEO da OpenAI, disse que a memória do ChatGPT permite que ele se lembre de conversas passadas e “te conheça ao longo da vida”. Mas isso é útil ou assustador?

A privacidade da IA diz respeito a como suas informações pessoais são coletadas, usadas e compartilhadas pelas empresas de IA. Isso inclui dados coletados da internet sem consentimento e informações que você mesmo fornece ao usar a IA, por exemplo, em prompts.

Mesmo com esses riscos, muitas pessoas compartilham seus dados pessoais em troca da conveniência de usar apps, sites e agora ferramentas de IA. Para crianças e adolescentes, a proteção de dados e privacidade é ainda mais relevante. Ao utilizarem a IA para aprender, pesquisar, escrever ou até pedir conselhos pessoais, dados sensíveis podem ser compartilhados. Em agosto de 2025, a Câmara dos Deputados aprovou o projeto de Lei que cria regras e obrigações para os fornecedores para a proteção de crianças e adolescentes quanto ao uso de aplicativos, jogos eletrônicos, redes sociais e programas de computador.

Outro fenômeno associado à vigilância é o colonialismo digital, modelo de negócio das Big Techs que lucram com a modulação de comportamentos e influenciam até em processos democráticos.

IA E EDUCAÇÃO: PERSPECTIVAS CRÍTICAS PARA UM CAMPO EM CONSTRUÇÃO

Acesse aqui o resumo em Português